کرال باجت یا بودجه خزش (crawl budget) تعداد صفحاتی است که ربات گوگل یا گوگل بات (Googlebot) یک بار و در یک دوره زمانی معین (روزانه) از یک وب سایت، ردیابی می کند. (یعنی روزی یک بار)

گوگل بات یا همان Googlebot یک خزنده وب است که وظیفه اش جمع آوری اطلاعات صفحات وب سایت های گوناگون و ارسال آن به سرورهای گوگل جهت آپدیت ایندکس گوگل است.

مکس سیرِک می گوید: براساس آزمایش خودم، PLT (زمان بارگذاری صفحه) و CBR (رتبه کرال باجت) جنبه های فنی هستند که به اعتقاد من موفقیت وب سایت یا عدم موفقیت وب سایت در سال جدید را تعیین می کند.

Google این توانایی را دارد که قوانین خود را از نظر محتوا و شفافیت اطلاعات و هم چنین کیفیت فنی به صاحبان وب سایت تحمیل کند. به همین دلیل جنبه های فنی که اکنون بیشتر به آن ها توجه می کنم، سرعت وب سایت ها در زمینه زمان های مختلف بارگزاری صفحه است که من به PLT (زمان بارگذاری صفحه) می گویم.

زمان برای اولین بایت (TTFB)، زمان پاسخ گویی سرور از ارسال درخواست تا ارسال اولین بایت اطلاعات است. این نشان می دهد که چگونه یک وب سایت از منظر یک سرور (اتصال بانک اطلاعاتی، پردازش اطلاعات و سیستم ذخیره داده ها و هم چنین عملکرد سرور DNS) کار می کند. TTFB را چگونه بررسی می کنید؟ ساده ترین راه استفاده یکی از ابزارهای زیر است:

ابزارهای توسعه دهنده (دولوپر) در مرورگر کروم

WebPageTest

بررسی بایت

تفسیر نتایج

زمان برای اولین بایت (TTFB) زیر 100ms نتیجه موثر می دهد. در توصیه های Google، زمان TTFB نباید از 200ms تجاوز کند. معمولاً اتخاذ می شود که زمان پاسخ گویی قابل قبول سرور که برای دریافت اولین بایت محاسبه می شود، احتمالا از 0.5s تجاوز نکند. بالاتر از این مقدار، ممکن است در سرور مشکلی ایجاد شده، بنابراین اصلاح آن ها باعث بهبود نمایه سازی و نمایش وب سایت می شود.

بهبود TTFB

1. وب سایت را تجزیه و تحلیل کنید با بهبود بخش هایی از کد مسئول پرس و جوهای پایگاه داده مصرف کننده منابع (به عنوان مثال پیوند چندین سطح) یا بارگذاری کد سنگین پردازنده (مانند تولید ساختارهای داده درخت پیچیده در پرواز، مانند ساختار دسته بندی یا تهیه تصاویر کوچک قبل از نمایش نما بدون استفاده از مکانیسم های ذخیره).

2. از یک شبکه تحویل محتوا (CDN) استفاده کنید. این استفاده از شبکه های سرور پراکنده در سراسر جهان است که محتواهایی مانند CSS، پرونده های JS و عکس از سرورهای نزدیک به شخصی را که می خواهد یک وب سایت خاص را ببیند فراهم می کند. به لطف CDN، منابع مانند صفحات سرورهای کلاسیک صف نمی شوند و تقریباً به صورت موازی بارگیری می شوند. اجرای CDN زمان TTFB را تا 50٪ کاهش می دهد.

3. اگر از هاست مشترک استفاده می کنید، مهاجرت به یک سرور VPS با منابع تضمین شده مانند حافظه یا قدرت پردازنده یا سرور اختصاصی را در نظر بگیرید. این تضمین می کند فقط شما می توانید بر عملکرد یک دستگاه (یا یک ماشین مجازی در مورد VPS) تأثیر بگذارید. اگر چیزی به آرامی کار می کند، احتمالا مشکلات از طرف شما باشد، نه لزوماً سرور.

4- در مورد اجرای سیستم های اجرای حافظه پنهان فکر کنید. در مورد وردپرس، افزونه های زیادی برای انتخاب وجود دارد که اجرای آن مشکلی ندارد و اثرات آن فوری خواهد بود. WP Super Cache و W3 Total Cache افزونه هایی هستند که من اغلب از آن ها استفاده می کنم. اگر از راه حل های اختصاصی استفاده می کنید، پیاده سازی های Redis ، Memcache یا APC را در نظر بگیرید که به شما امکان می دهد داده ها را روی فایل ها ریخته یا آن ها را در رَم ذخیره کنید، که می تواند باعث افزایش کارایی شود.

5- پروتکل HTTP / 2 را فعال کنید یا اگر سرور شما از این ویژگی برخوردار است، HTTP / 3 را فعال کنید. مزایا در قالب سرعت، چشمگیر است.

زمان پردازش DOM

زمان پردازش DOM زمان بارگیری همه کد HTML است. هرچه کد قابل اجرا تر باشد، منابع کم تری برای بارگیری آن لازم است. مقدار کم تری از منابع مورد نیاز برای ذخیره یک وب سایت در فهرست موتور جستجو، سرعت و رضایت کاربر را بهبود می بخشد.

من طرفدار کاهش حجم کد HTML با حذف کد HTML اضافی و تغییر عناصر نمایش داده شده در وب سایت از کد HTML به CSS هستیم. به عنوان مثال، من از شبه کلاس ها (pseudo classes) استفاده می کنم: قبل و بعد از و هم چنین حذف تصاویر با فرمت SVG از HTML (تصاویر موجود در <svg> </svg>).

زمان ارائه صفحه

زمان ارائه صفحه از وب سایت تحت تأثیر بارگیری منابع گرافیکی، هم چنین بارگیری و اجرای کد JS است.

کمینه سازی و فشرده سازی منابع یک عمل اساسی است که سرعت ارائه یک وب سایت را تسریع می کند. بارگذاری عکس به صورت غیر همزمان، کوچک سازی HTML، انتقال کد جاوا اسکریپت از HTML (مکانی که بدنه های تابع به طور مستقیم در HTML درج می شوند) به فایل های جاوا اسکریپت خارجی که در صورت نیاز بارگذاری می شوند.

این فعالیت ها نشان می دهد که بارگیری فقط کد جاوا اسکریپت یا CSS که در زیر صفحه (sub-page) فعلی مورد نیاز است، خوب است. به عنوان مثال، اگر کاربر در یک صفحه باشد، مرورگر مجبور نیست کد جاوا اسکریپت را که در سبد یا پنل کاربر وارد شده را استفاده کند.

هرچه منابع بیشتری نیاز به بارگیری داشته باشند، Google Bot باید زمان بیشتری را برای بارگیری اطلاعات مربوط به محتوای وب سایت صرف کند. اگر فرض کنیم هر وب سایت دارای حداکثر تعداد / حداکثر مدت بازدید از Google Bot – که با ایندکس کردن محتوا به پایان می رسد – تعداد کمتری از صفحات ما در این مدت به فهرست موتورهای جستجو ارسال خواهند شد.

رتبه کرال باجت (بودجه خزش)

موضوع آخری نیاز به توجه بیشتری دارد. کرال باجت به طرز چشمگیری در فهرست بندی محتوای Google Bot در وب سایت تأثیر می گذارد. برای درک نحوه کارکرد و کرال باجت آن، از مفهومی به نام CBR (رتبه کرال باجت) برای ارزیابی شفافیت ساختار وب سایت استفاده می کنم.

اگر Google Bot نسخه های مشابهی را در همان وب سایت پیدا کند، CBR ما کاهش می یابد. ما این را از دو طریق متوجه می شویم:

1. کنسول جستجوی گوگل

با تجزیه و تحلیل و ارزیابی مشکلات مربوط به نمایه سازی صفحه در کنسول جستجوی گوگل، می توانیم در بخش هایی مانند:

وب سایت اسکن شده اما هنوز ایندکس نشده

انتقال محتوای وب سایت

کپی کردن، گوگل یک صفحه متعارف متفاوت از کاربر انتخاب کرده است

کپی کردن، کاربر صفحه متعارفی را علامت گذاری نکرده است

2. Access Log

این بهترین منبع اطلاعات در مورد خزش Google Bot وب سایت ما است. بر اساس داده های Log، می توانیم ساختار وب سایت را برای شناسایی نقاط ضعف در معماری ایجاد شده توسط لینک های داخلی و عناصر نویگیشن درک کنیم.

رایج ترین خطاهای برنامه نویسی که روی مشکلات نمایه سازی اثر می گذارد عبارتند از:

1. فیلترینگ ناقص داده ایجاد شده و مکانیسم های مرتب سازی و در نتیجه ایجاد هزاران زیر صفحه (sub-page) تکراری و کپی شده

2. لینک های “نمایش سریع” که در نسخه کاربر، پاپ – آپ را با داده هایی بر روی لایه نمایش می دهد و یک وب سایت با اطلاعات مربوط به محصول تکراری ایجاد می کنند.

3. صفحه بندی که هرگز تمام نمی شود.

4- لینک هایی در وب سایت منتشر شده است که به آدرس های جدید به منابع هدایت می شوند.

5- مسدود کردن دسترسی برای ربات ها به منابع مکرر تکراری.

6. خطاهای معمولی 404.

CBR ما کاهش می یابد اگر “آشفتگی” وب سایت ما افزایش یابد، به این معنی که Google Bot تمایل کمتری به بازدید از وب سایت ما (فرکانس پایین)، ایندکس کمتر و محتوای کمتر دارد و در صورت تفسیر اشتباه از نسخه مناسب منابع، صفحات قبلی را در فهرست موتور جستجو حذف می کند.

مفهوم کرال باجت (بودجه خزش) کلاسیک، به ما این ایده را می دهد که Google Bot در روز (براساس پرونده های ثبت شده) در چند صفحه در مقایسه با کل صفحات سایت می خزد. در اینجا دو احتمال وجود دارد:

1. سایت شما دارای 1000 صفحه است و Google Bot هر روز در 200 مورد از آن ها می خزد. چه چیزی به شما می گوید؟ آیا نتیجه منفی است یا مثبت؟

2. سایت شما دارای 1000 صفحه است و Google Bot در 1000 صفحه می خزد. آیا باید خوشحال باشید یا نگران؟

بدون گسترش مفهوم کرال باجت با معیارهای با کیفیت اضافی، اطلاعات به همان اندازه مفید نیستند. مورد دوم ممکن است یک صفحه بهینه شده باشد یا یک مشکل بزرگ را نشان دهد. فرض کنید اگر Google Bot فقط 50 صفحه ای که شما می خواهید را بخزد و بقیه (950 صفحه) دارای صفحات محتوای ضعیف / تکراری و کپی شده / بی ارزش هستند. پس ما یک مشکل داریم.

من برای تعریف یک استاندارد رتبه کرال باجت کار کرده ام. مانند رتبه صفحه، هر چه رتبه صفحه بالاتر باشد، لینک های خروجی قوی تر هستند. هرچه CBR بزرگ تر باشد، مشکلات کمتری خواهیم داشت.

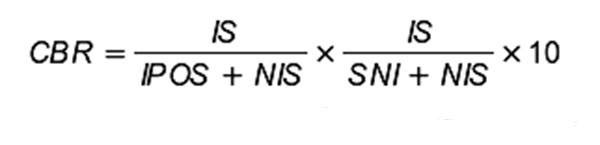

تعبیر عددی CBR می تواند به شرح زیر باشد:

IS – تعداد وب سایت های ایندکس شده که در نقشه سایت ارسال شده (نقشه سایت ایندکس شده)

NIS – تعداد وب سایت های ارسال شده در نقشه سایت (نقشه سایت ایندکس نشده)

IPOS – تعداد وب سایت هایی که در نقشه سایت اختصاص ندارند (صفحات ایندکس شده خارج از نقشه سایت)

SNI – تعداد صفحات اسکن شده اما هنوز ایندکس نشده

بخش اول این معادله وضعیت یک وب سایت را در چارچوب آن چه ما می خواهیم موتور جستجو ایندکس کند (وب سایت های موجود در نقشه سایت همان هایی هستند که می خواهیم آن ها را ایندکس کنیم) در مقابل واقعیت، یعنی آن چه Google Bot به دست می آورد و ایندکس می کند حتی اگر ما آن را نمی خواستیم. در حالت ایده آل، IS = NIS و IPOS = 0 است.

در بخش دوم این معادله نگاهی داریم به تعداد وب سایت هایی که Google Bot در برابر پوشش واقعی در ایندکس رسیده است. مانند بالا، در شرایط ایده آل، SNI = 0.

مقدار حاصل ضرب شده در 10 عددی بیشتر از صفر و کمتر از 10 به ما می دهد. هرچه نتیجه به 0 نزدیک تر باشد، باید روی CBR کار کنیم.

این فقط تفسیر خود من است که بر اساس تحلیل پروژه هایی که امسال به آن ها پرداخته ام، است. هرچه بیشتر بتوانم این فاکتور را بهبود بخشم (افزایش CBR)، دید، موقعیت و در نهایت افزایش ترافیک در وب سایت بهبود می یابد.

اگر فرض کنیم CBR یکی از عوامل رتبه بندی مؤثر بر رتبه بندی کلی دامنه است، من آن را بلافاصله بعد از رتبه بندی خارج از سایت به عنوان مهم ترین عامل در سایت تعیین می کنم. توضیحات منحصر به فرد برای کلمات کلیدی انتخاب شده با توجه به محبوبیتی که Google Bot امکان ایجاد این اطلاعات را در فهرست موتور جستجو ندارد، بهینه شده است؟

محتوای اول کاربر

ما شاهد یک انقلاب بزرگ دیگر در خواندن و تفسیر نمایش داده ها و مطالب در وب سایت ها هستیم. از نظر تاریخی، چنین تغییرات بی سابقه ای شامل موارد زیر است:

1. استانداردهای کمیت – 1000 کاراکتر با فاصله و سه کلمه کلیدی پول در محتوا. تا لحظه معینی ضمانت موفقیت بود، روزی آن را به سادگی از دست داد.

2. محتوای ضعیف – ترافیک ساخته شده بر روی برچسب ها (تگ ها) پر از کلمات کلیدی. شبانه، این استراتژی کار خود را متوقف کرد که محتوای کم کیفیت ساختگی (متن درهم و آشفته) نیز ایجاد کرد.

3. محتوای تکراری – Google Bot یاد گرفته است (کم و بیش خوب) کدام متن ایندکس شده در موتور جستجو اصلی است (ابتدا ایجاد شده) و کدام کپی است. در نتیجه، پاندا (الگوریتم گوگل) ایجاد شد. هر چند ماه یک بار وب سایت های با کیفیت پایین فیلتر و علامت گذاری می شد و باعث کاهش رتبه آن ها، هم چنین کاهش موقعیت آن در موتور جستجو می شد. در حال حاضر به حالت “زنده” کار می کند.

4. رنک برین (Rank Brain) – یک برنامه هوش مصنوعی است که برای پردازش درخواست های جستجو در گوگل مورد استفاده قرار می گیرد. الگوریتمی که با استفاده از یادگیری ماشین، پرس و جوهای کاربران موتور جستجو را با تأکید کمتر بر کلمات کلیدی و سایر موارد در زمینه پرس و جو (از جمله تاریخ پرس و جو) تفسیر می کند و هم چنین نتایج خاص تر را نمایش می دهد.

5. E-A-T – حذف محتوا که به دلیل کم بودن اقتدار نویسنده محتوا و در نتیجه دامنه ها، گمراه کننده یا احتمالاً گمراه کننده است. این امر به ویژه صنعت پزشکی و مالی را تحت تأثیر قرار داد. هرگونه مقاله ای که توسط متخصصین ایجاد نشده باشد، اما در مورد حوزه های حیاتی است، می تواند خسارات زیادی به بار آورد. از این رو، گوگل با دامنه هایی که از نظر محتوای و کیفیت ضعیف هستند، نبرد می کند.

ایجاد محتوا برای کلمات کلیدی خاص، اهمیت خود را از دست می دهد. در صورتی که محتوا به عنوان مطلبی طبقه بندی شود که با اهداف کاربر و در زمینه جستجو مطابقت داشته باشد، مقالات طولانی بسته بندی شده با عبارات فروش از بین می روند تا مقالات کوتاه با مضمون در رتبه های بهتر قرار گیرند.

بِرت (BERT)

بِرت مخفف (Bi-directorial Encoder Representations from Transformers) یک الگوریتم متن باز (Open Source) گوگل است که می تواند مفهوم هر کلمه را در یک جستجو نسبت به دیگر کلمات آن پردازش کند. به عنوان مثال، سوال – چه مدت می توانید بدون ویزای معتبر در ایالات متحده بمانید؟ – می تواند هم نتایج وب سایت هایی را نشان دهد که می توانیم بسته به کشور مبدا اطلاعاتی راجع به مدت ویزا پیدا کنیم (به عنوان مثال برای جستجوی اروپا)، و هم چنین مواردی که درباره شخصی که ویزایش منقضی می شود، یا توصیف چگونه می تواند اطلاعاتی را نشان دهد. اقامت شخص در ایالات متحده را قانونی کنید.

آیا امکان ایجاد محتوای کامل وجود دارد؟ جواب ساده است – نه. با این حال ، ما می توانیم محتوای خود را بهبود بخشیم.

در فرآیند بهبود محتوا به گونه ای که متناسب تر باشد، می توانیم از ابزاری مانند ahrefs (برای ساختن الهامات محتوا بر اساس تجزیه و تحلیل رقابت)، semstorm (برای ساخت و آزمایش نمایش داده های طولی از جمله جستجو در قالب سوالات) و surferseo استفاده کنیم. (برای محتوای مقایسه ای وب سایت ما با صفحات رقابت در SERP)، که اخیراً یکی از ابزارهای مورد علاقه من است.

در حالت دوم، ما می توانیم “روش های خوب” متداول را کنار بگذاریم که می توان در صفحات رقابت که ترافیک موتور جستجو در درون خودشان جستجو و پیدا می کنند، تجزیه و تحلیل مقایسه ای را در سطح کلمات، عبارات مرکب، برچسب یا تگ های HTML (به عنوان مثال پاراگراف ها، حروف برجسته و سر صفحه) انجام دهیم.

این تا حدودی یک بهینه سازی مصنوعی از محتوا است، اما در بسیاری از موارد من با محتوایی که با استفاده از داده های جمع آوری شده توسط ابزارهای فوق اصلاح کردم، توانستم ترافیک وب سایت ها را با موفقیت افزایش دهم.

نتیجه

همان طور که همیشه می گویم، هیچ روش واحدی برای توجه به سئو وجود ندارد. تست ها به ما نشان می دهند که آیا این استراتژی، چه در رابطه با ایجاد محتوای یک وب سایت و چه از خود محتوا، خوب خواهد بود.

نوشته: ماکس سایرک

ترجمه: سمیه مظفری